火山引擎,重新定义“好模型”

图片来源于网络,如有侵权,请联系删除

谈及现下科技领域最火热的话题,当属以生成式AI技术为核心的大模型。大模型自身在飞速迭代的同时,也在悄然进入各行各业,深刻改变人类的生活和工作方式。

据麦肯锡报告分析,大模型的价值创造潜力惊人,到2030年,有望在全球推动49万亿人民币的经济增量。这里面既包括大模型对现有工作效率的提升,也包括新技术所带来的新场景和新业态。

图片来源于网络,如有侵权,请联系删除

我们先来感受以下两类场景:

“How are you?”“I will teach you English. Any questions?”

——这是一款名为“青蛙外教”的智能体应用发出的对话,它的各项功能已经相对完整,然而背后的开发者,是一个还在北京上小学五年级的小朋友。这个小朋友通过字节的扣子平台,非常容易就独自完成了外教智能体的全部开发工作,并将其分享给了同学朋友们一起使用。

第二类场景聚焦于一位每天需要面对许多客户的汽车销售,他拥有一个可以辅助销售工作的AI助手。

——早上开始工作前,AI助手就根据销售前一天的工作内容和与沟通过程,总结好了当天的关键信息和代办事项,帮助销售进行工作思路的梳理;在接待客户的过程中,AI助手随时准备好解答一些复杂的问题,并进一步为客户生成包括折扣、贷款和保险在内的专属综合方案;最后在下班结束前,AI助手总结这一天的经验教训,给出优秀话术的学习经验,并且模拟扮演客户,与销售进行交流演练,不断提升他的技巧。

可以看到,不论是To C还是To B,大模型应用场景正加速并“花式”落地,这两个例子也只是众多应用场景中的一隅,随着大模型技术的不断发展,企业与开发者都在积极投身于这片蓝海。“在未来的一年里,大模型将在越来越多的企业场景中,从POC阶段走到真实的生产系统。”火山引擎总裁谭待如是判断。

企业对大模型的现实需求非常明确,如提升创新能力、降本增效以及打造差异化优势等等,但企业要真正做好大模型的落地并非易事,既要重视模型效果,也要考虑推理成本,落地过程中工具、经验、平台的缺乏,亦是不小的挑战。

那么,什么才是好的大模型?怎样才能用更好的模型助力企业数智化,进而以AI普惠推动更多行业的创新力量迸发?背后的答案和逻辑其实很简单。

效果好:使用应用缺一不可

首先,好的大模型一定是在不断应用、持续打磨中才能形成。

“只有在真实场景中落地,用的人越多,调用量越大,模型才会越来越好。”谭待表示,一年前,字节跳动就完成了自主研发大模型,在内部,它被亲切地称为“豆包”,也是国内首批通过算法备案的大模型之一。

短短一年内,豆包大模型的“量”是怎么快速跑出来的?

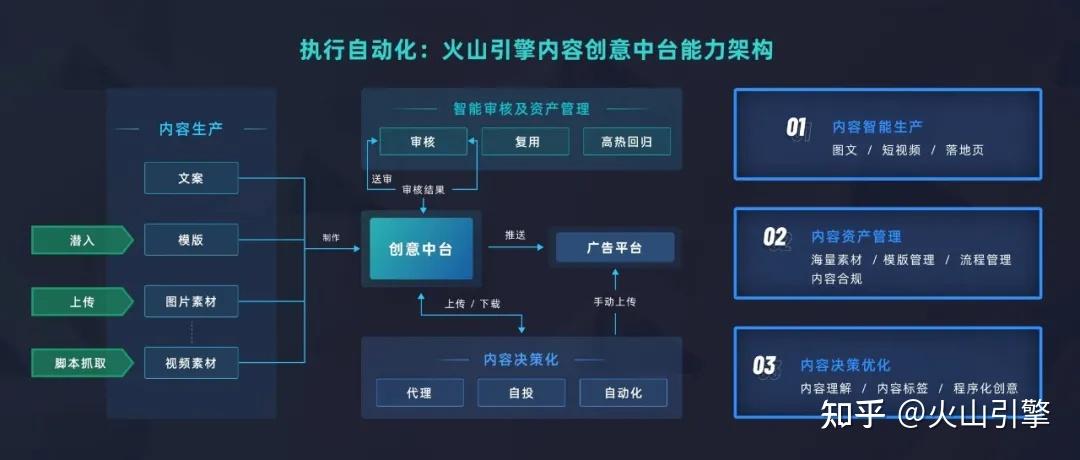

一方面,基于豆包大模型,字节跳动打造了AI对话助手“豆包”、AI应用开发平台“扣子”、互动娱乐应用“猫箱”,以及星绘、即梦等AI创作工具,并把大模型接入抖音、番茄小说、飞书、巨量引擎等50余个业务,用以提升效率和优化产品体验。

字节跳动产品和战略副总裁朱骏认为,技术在快速演化,但用户核心的需求没有改变,包括高效获取信息、工作提效、自我表达、社交娱乐等等。“我们做了很多学习和探索,希望找到适合的大模型应用形态,以足够自然的交互方式,为用户的生活和工作带来便利。”

另一方面,在服务字节内部的同时,豆包大模型也在与火山引擎的众多企业客户合作共创,包括手机、汽车、金融、消费、互娱等多领域,涵盖不同业务场景。为此,“豆包大模型提供的是一个有多模态能力的模型家族,目前主要包括通用模型pro、通用模型lite、语音识别模型、语音合成模型、文生图模型等九款模型。”谭待说。

豆包大模型

5月15日,字节跳动豆包大模型在火山引擎原动力大会上正式发布。几组数据很是醒目:

截至目前,豆包大模型日均处理1200亿Tokens文本,生成3000万张图片;

在苹果App Store和各大安卓应用市场,豆包App的下载量在AIGC类应用中排名第一;

豆包上已有超过800万个智能体被创建,月度活跃用户达到2600万。

这意味着,经过一年时间的迭代和市场验证,豆包大模型正成为国内使用量最大、应用场景最丰富的大模型之一。

而模型若想效果好的关键也系于此,即在学习更多场景和样本基础上,持续优化算法,提高模型预测和决策的准确性,更深刻地理解、更好地满足多样化的用户需求;迭代过程中,通过大量用户的使用和反馈,更全面地修正模型潜在的错误和偏见,降低模型安全风险。

定价低:AI普惠推动创新

尽管市场火热、千帆竞发,一个明确的现实是,目前大模型应用发展仍处于早期阶段。

QuestMobile数据显示,截至今年3月,基于大模型的AIGC行业用户量为7380万,尽管同比增长了8倍,也仅占移动互联网用户量的6%。

而谭待认为,降低成本是推动大模型快进到“价值创造阶段”的一个关键因素。因此,豆包大模型的定价大幅低于行业价格:以豆包通用模型pro-32k版为例,模型推理输入价格仅为0.0008元/千Tokens。而市面上同规格模型的定价一般为0.12元/千Tokens,是豆包模型价格的150倍。

什么概念?再换种说法,大模型从以分计价跃至以厘计价,0.8厘就能处理1500多个汉字,比行业便宜99.3%。

再具象些,以一本约75万字的《三国演义》为参照,如今通过豆包大模型花1块钱,即可获得125万个Token——大约3本《三国演义》的文字处理量。

如此幅度击穿行业底价,“卷”起价格战,火山引擎面临两个必须回答的重要问题:一是能否做到效果与成本的兼顾,二是定低价的直接与深层次原因。

火山引擎总裁谭待公布豆包大模型定价

“第一点就是我们能做到,第二点就是我们需要这么做。”谭待说,在技术和工程上,火山引擎自身有非常多的优化手段,比如模型结构的优化调整、从单机推理到分布式推理的进阶、混合调度的运用等,能够把底层的算力用得更好,大大降低成本。

在“能做到”的前提下,谭待与火山更多思考的是市场真正的需求,以及一荣共荣的行业长远发展。

进入2024年,随着大模型能力的提升,应用端的突破显得尤为重要,“一定要把生态繁荣”。许多企业都想尽早进行AI转型,做大模型的尝试,但创新的风险系数很高,常常面临许多不确定性。“我们必须要把试错的成本降得非常低,才能够让大家广泛地用起来,不管是大的企业还是个人。”

一言以蔽之,企业以极低成本使用AI大模型,可以充分试错和验证,在优化产品和服务、提升组织效率、降低成本等方面实现正向收益。站在更高处看,AI普惠亦将推动更多行业和产业科技创新,助力更多企业把握技术变革带来的新机遇,同时也会为用户带来更丰富的智能化体验。

火山引擎重新定义“好模型”的愿景应在于此——帮助企业无负担地进入AI大潮,一起成为价值创造的“弄潮者”。

【责任编辑:郑伟】版权声明

本文仅代表作者观点,不代表xx立场。

本文系作者授权xxx发表,未经许可,不得转载。